文摘

背景

非线性回归,如线性回归,在理想假设数据的散点曲线遵循一个高斯分布或正态分布。这种假设导致回归的熟悉目标:最小化的平方和的垂直或y值点和曲线之间的距离。离群值可以主导sum-of-the-squares计算,导致误导的结果。然而,我们不知道实际的方法定期识别异常值与非线性回归拟合曲线时。

结果

我们描述一个识别异常值的新方法与非线性回归拟合数据。我们首先满足非线性回归的数据使用一个健壮的形式,基于假设散射是一个洛伦兹分布。我们设计了一种新的自适应方法,逐渐变得更加健壮的方法所得。定义异常值,我们适应了错误发现率的方法来处理多个比较。然后删除离群值,并使用普通最小二乘回归分析数据。因为结合了稳健回归方法和离群值删除,我们称之为溃败的方法。

在分析模拟数据,所有散射是高斯,我们的方法检测(错误地)一个或多个异常值只有1 - 3%的实验。在分析数据含有一个或多个异常值时,溃败在异常识别方法执行好,平均错误发现率不到1%。

结论

我们的方法,该方法结合了一种新的鲁棒非线性回归方法和异常识别的新方法,识别异常值的非线性曲线符合合理的权力和一些假阳性。

背景

非线性回归,如线性回归,在理想假设数据的散点曲线遵循一个高斯分布或正态分布。这种假设导致回归的熟悉目标:最小化的平方和的垂直或y值点和曲线之间的距离。然而,实验错误可能导致错误的价值观——离群值。甚至一个局外人可以主导sum-of-the-squares计算,并导致误导的结果。

识别异常值是很棘手的。即使所有散射来自一个高斯分布,有时将远离点休息。在这种情况下,删除这一点会降低结果的准确性。但是一些异常值是一个实验的结果错误,所以不来自其他点的分布。这些观点将主导的计算,可能会导致不准确的结果。删除这样的异常值将提高分析的准确性。

消除异常值往往是在一个完成的特别的的方式。这样一个非正式的方法,客观是不可能一致的,或者文档的过程。

设计了几个正式的统计测试来确定一个值是一个局外人,综述了(1]。如果你有大量的复制点在每个X的值,你可以用这样一个测试每组复制判断一个值是一个重要的例外。不幸的是,没有离群值测试基于复制将每个点是有用的在典型情况下只测量一次或几次。一种选择是进行异常测试的整个残差集(每个点的距离曲线)的最小二乘回归。这种方法的问题是,离群值可以影响曲线拟合,以至于没有进一步的拟合曲线比其他点,所以它的残余将不会标记为局外人。

而不是删除离群值,另一种方法是适合所有数据(包括任何局外人)使用一个健壮的方法,提供异常值有影响最小(2,3]。健壮的配件可以找到合理的最佳模型的参数值,但不能用于比较适合的替代模型。此外,据我们所知,没有强大的非线性回归方法提供了可靠的参数置信区间或信心乐队曲线。因此,健壮的配件单独是一个还没有一种方法可以建议常规使用。

所显示Hampel [2我们结合鲁棒回归与异常值检测。它遵循三个步骤。

- 1。

适合使用一种新的鲁棒非线性回归方法曲线。

- 2。

分析健壮的适合的残差,并决定是否一个或多个值是离群值。为此,我们开发了一个新的异常测试改编自测试的错误发现率的方法对多个比较。

- 3所示。

删除离群值,对其余数据执行普通最小二乘回归。

我们在本文详细描述方法,通过分析模拟数据集显示其属性。因为结合了稳健回归方法和离群值删除,我们称之为溃败的方法。

结果

简短的描述方法

论文的最后部分的方法解释了数学细节。我们现在用的概述如何击溃方法的两个部分(稳健回归其次是离群值识别)工作。

强大的非线性回归

的配合将被用作一个“基线”来检测异常值。是很重要的,因此,健壮的方法给很少的重量非常狂野的离群值。由于我们预计,这种方法常常被用于一个自动化的方式,也是重要的方法不是很容易被错误的最小和过于敏感的选择初始参数值。令人惊讶的是,我们没有能够找到现有的稳健回归方法,满足所有这些标准。

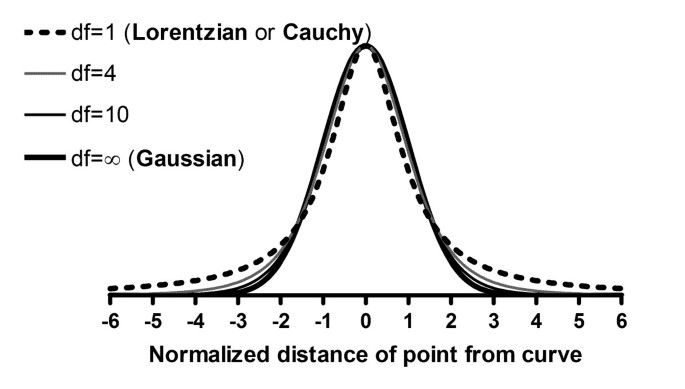

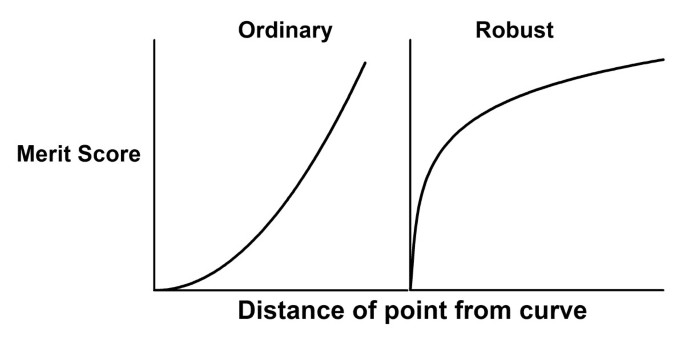

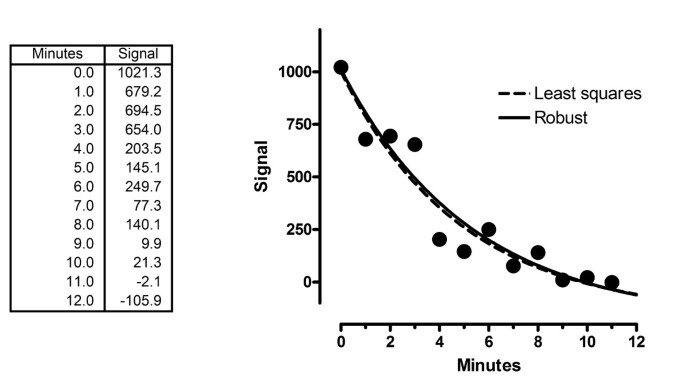

基于一个建议数值的食谱(4),我们我们健壮的拟合方法基于的假设变化曲线遵循一个洛伦兹分布,而非高斯分布。发行版都是家庭的一部分t分布如图1。图的广泛分布,df = 1 t分布,也被称为洛伦兹分销或柯西分布。洛伦兹分布广泛的尾巴,所以异常值是相当常见的,因此对健康几乎没有影响。

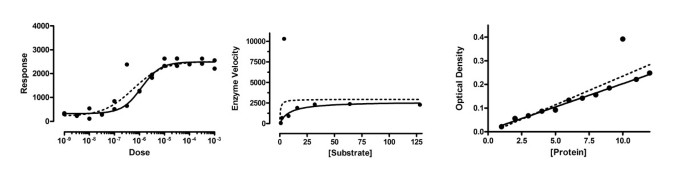

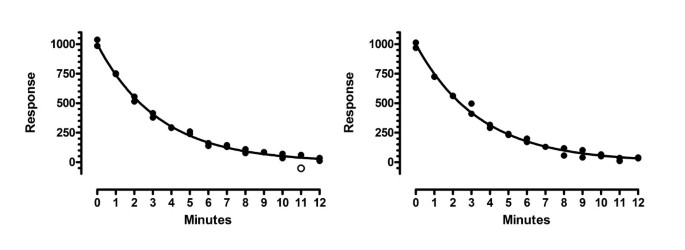

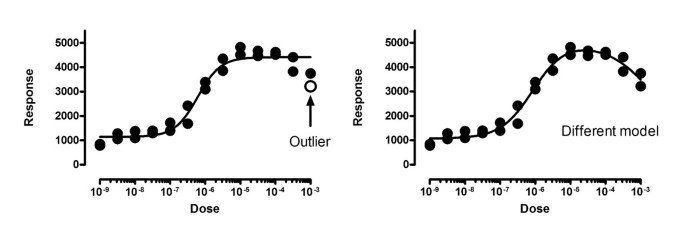

我们适应了马夸特非线性回归算法,以适应洛伦兹的假设(而不是高斯)残差的分布。图2显示了三个数据集包括一个异类。坚实的曲线显示我们强大的非线性回归的结果,几乎不受异常值影响。相比之下,虚线曲线显示了最小二乘结果,极大地受到异常值的影响。

我们的方法适合数据尽快接近普通的非线性回归,不需要额外的选择。的拟合方法报告参数的最佳值,但没有报告这些值的标准错误或置信区间。

最小二乘回归量化数据的散点曲线的报告y.x,有时被称为e的标准误差。它是通过计算之比的平方根平方和除以自由度的数目(N - K,其中N是数据点的数量和K是可调参数的数量)。年代y.x是在同一个单位Y值,并且可以认为是残差的标准差。

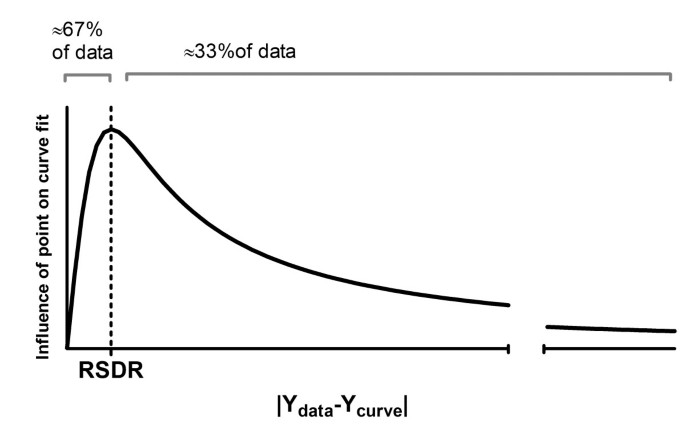

一个异类的存在会大大增加的价值y.x。因此,我们使用一个替代方法来量化生成的曲线周围的散射点的鲁棒非线性回归。我们量化的散射计算残差的绝对值的68.27百分位(因为68.27%的值在一个高斯分布位于一个标准差的平均值)。我们称之为价值(n校正方法中所描述的部分)的残差的标准差(RSDR)。

异常值检测

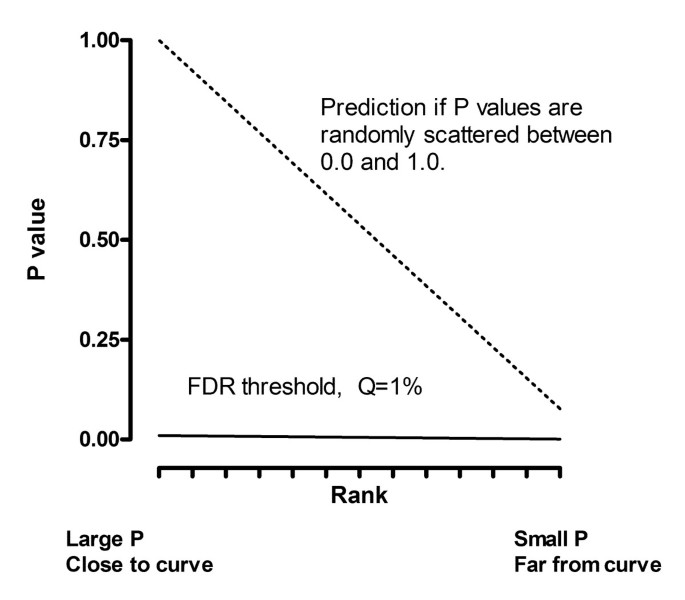

使用鲁棒非线性回归拟合曲线后,需要一个阈值决定当一个点是足够远的曲线要宣布一个异类。我们认为这是非常相似的问题看的许多P值和选择一个阈值决定何时P值足够小,被宣布“显著”。

当制作多个统计比较,你画之间的界线在哪里“重要”和“不重要”?如果使用传统的5%显著性水平为每一比较,没有调整为多个比较,你会得到大量的假阳性。Bonferroni方法使用一个较低的截止定义为5%除以家庭的数量比较。这是一个有用的工具当你在做一些比较,但不太有用,当你做多的比较可以错过很多真正的发现(换句话说,它没有统计力量)。Benjamani和业务5,6)开发出一种方法来处理多个比较,不仅考虑数量的比较,P值的分布在集。使用该方法时,您将值设置问为了控制错误发现率(罗斯福)。如果问设置为1%,你可以预计不到1%的具有统计学意义的结果(发现)假阳性,其余(超过99%)是真实的。

我们适应了罗斯福的概念创建一个新颖的方法来识别一个或多个异常值。首先每个剩余除以RSDR。这个比例接近一个t分布,可以用来获得的小动物——一张长有P值。现在使用这些P值的罗斯福方法来确定哪些是“重要”,并定义相应的点是离群值。

选择一个适当的值Q

离群值消除由罗斯福技术要求您选择一个问:如果Q值很小,那么很少的优点将会误认为是“局外人”,但发现真正的离群值较低的权力。如果问比较大,那么权力找到真正的离群值高,但更多的优点将会错误地认定为异常值。

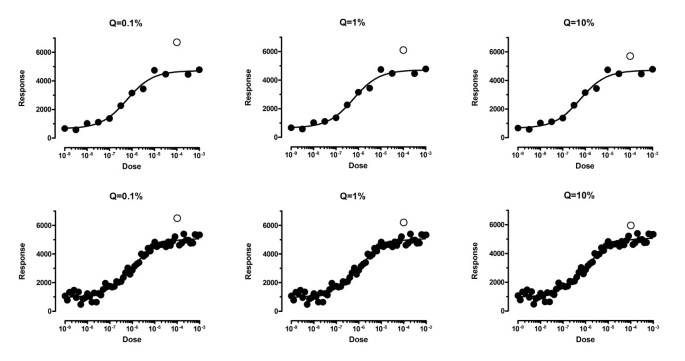

曲线图在图3显示的结果设置问0.1%、1%或10%。在每个图,有一个离群值(开放的象征),超出了离群值的边界检测。在任何情况下,如果点移动一点点接近曲线,将不再被作为一个局外人。

如果问设置为10%,离群值去除似乎有点过于激进。开放的圈子在右面板不都远离其他点。如果问设置为0.1%,如图所示的两个图在左边,离群值去除似乎有点太胆小。点必须非常远离其他被检测出来。中间的两个图形板问设置为1%。选择是主观的,但我们选择问至1%,尽管会有有意义的情况下设置问更低或更高的价值。

如果所有的散射是高斯,多少误认为是“离群值”?

我们模拟的18种不同情况下(不同的模型,不同数量的参数,不同数量的数据点)。对于每一个,我们模拟10000数据集添加高斯误差,分析结果与溃败方法(Q值设置为1%),并记录有多少离群值(错误地)消除。数据点的分数消除“局外人”,范围从0.95%到3.10%,平均为1.5%。没有观察到明显的相关性分数点消除“局外人”,并选择模型,样本大小或数量的分散但我们没有深入调查这些联系。

单一的异常值检测到有多好?

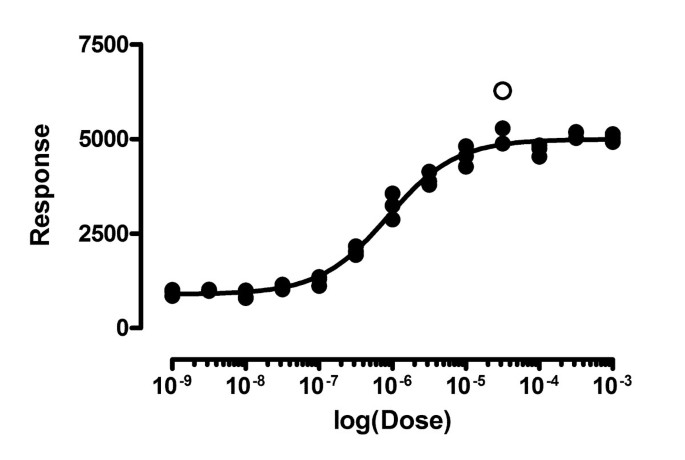

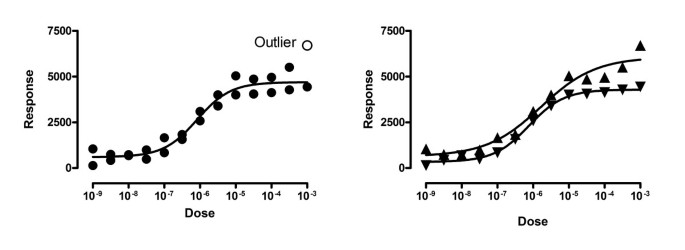

图4显示了一个情况的一个数据点与曲线进一步比休息。我们5000年模拟散射实验通过生成高斯散标准差为200,并添加一个局外人,1400 Y单位远离曲线(显示为一个开放的循环)。

确定极端异常值。这表明5000年第一个模拟数据集和一个离群值(打开符号)的距离理想的曲线方程7倍标准差的高斯散点剩余的点。我们的方法检测到这样的局外人除了5 5000个模拟的数据集,而错误地定义很少的优点是局外人(错误发现率= 1.18%)。

溃败方法(Q值设置为1%)发现除了5中的离群值的模拟。此外,它偶尔会错误地认为“好”点是离群值。95年确定一个点是一个离群值模拟实验中,两个点在14个实验中,三分在一个实验中,四个点在一个实验中,和五个点在一个实验中。为每个模拟实验,我们表示错误发现率(罗斯福)的“优点”错误地分类为离群值除以总数量的异常值检测。一些实验,未发现异常值,定义了罗斯福等于0.0。罗斯福5000年模拟实验的平均值为1.18%。

图5显示了不同的前两个系列的模拟。这里的异常值曲线的距离等于4.5倍标准差的高斯散。这使得局外人难以检测。左边的面板显示了一个模拟的离群值检测(开环)。在右侧面板中,异常值X = 3分钟没有检测到。

5000年,溃败的方法模拟(Q设置为1%)发现了离群值在58.3%的模拟。此外,它错误地识别一个“好”点作为一个局外人在78年模拟实验,和两个10分,三分在2。罗斯福平均为0.94%。这个例子表明,我们的方法可以检测中度异常值在大多数情况下,维护错误发现率低于问我们设置的值。

多个异常值检测到有多好?

我们使用相同的设置如图4(异常值的曲线的距离等于7次高斯的SD散射)。当我们5000年模拟数据集与九(36分)被孤立,溃败的方法(Q设置为1%)发现异常值的86%,平均0.06%的罗斯福。有两个离群值,它检测到超过99%,平均0.83%的罗斯福。

我们也用温和的离群值模拟实验,使用相同的设置如图5。当我们5000年模拟实验两个离群值,57%的异常值检测到罗斯福的0.47%。当我们模拟实验26分5的离群值,28%的异常值检测到罗斯福的只有0.02%。

它是如何工作的,当散射不是高斯?

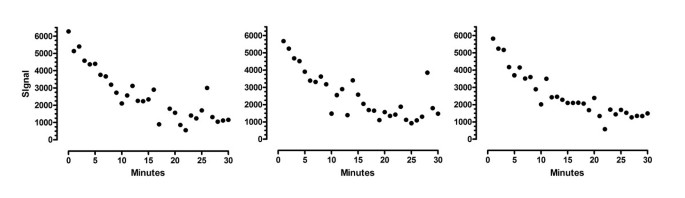

即使溃败的方法开发了分析数据的分散是高斯的一些异常值,我们想知道如果它也顺利当散射不是高斯。我们模拟的散射遵循1000数据集t分布在两个自由度。图6显示三个数据集,显示了广泛的分散。

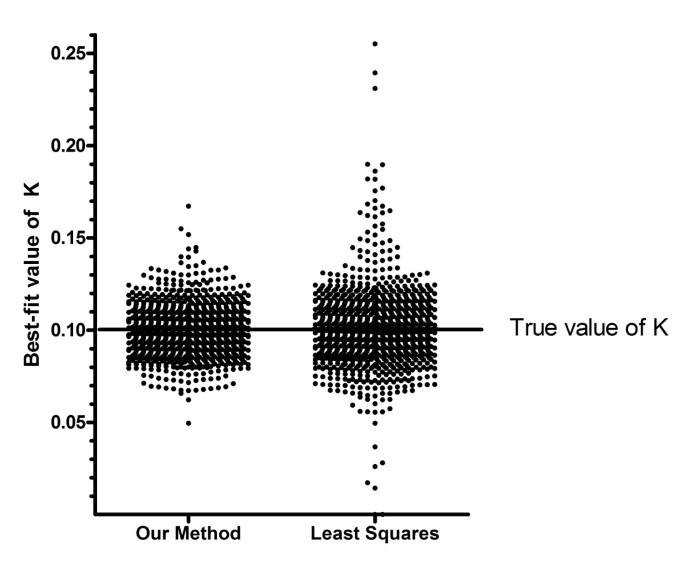

图7显示了最佳的速率常数k值,1000年模拟数据集分析通过普通最小二乘回归或我们outlier-removal方法。这两种方法找到正确的速率常数(K = 0.1)。但个人之间的散射模拟与标准最小二乘回归,而不是更大溃败的方法,具有较小的平均误差。

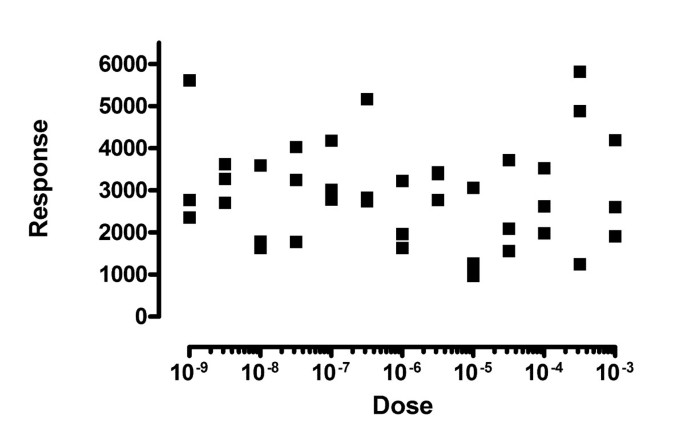

方法被垃圾数据吗?

一个担忧就是一个自动化异常拒绝方法可能报告看似有效的结果数据,完全是随机的,没有趋势。图8显示了1000年第一次模拟数据集,我们测试了这个想法。

我们这些模拟数据集乙状结肠剂量反应曲线,解决高原和斜坡底部,问这个项目适合高原和EC50顶部。曲线拟合方法(最小二乘或健壮的其次是消除异常值与Q设置为1%)能够适应曲线大约三分之二的模拟数据集,但其中多数EC50值范围以外的数据。只有132的模拟数据集EC50值范围内的数据(适合强劲或普通回归),和所有的R2值小于0.32。我们的离群值去除方法发现局外人在132年只有其中的一个模拟数据集。

这些模拟显示,击溃方法不发狂拒绝异常值,雕塑完全随机的数据模型。鉴于垃圾数据时,离群值拒绝方法很少发现异常值,所以几乎总是报告相同的结果(或缺乏)结果为最小二乘回归。

小数据集呢?

另一个担心是,离群值去除方法将与小数据集太咄咄逼人。为了验证这一点,我们模拟小的数据集参数(均值)或四个参数(可变斜率剂量反应曲线)。在这两种情况下,当自由度的数量是1或2 (N是第一种情况,2或3和5或6秒),我们的方法从来没有发现一个异类无论多远从其他点。当有三个自由度,偶尔的方法能够检测一个异类,但只有当它非常远离其他点,当其他点小散射。

这些模拟显示,击溃法并不疯狂拒绝离群值从小型数据集。

讨论

概述

普通最小二乘回归是基于假设周围的散射点拟合直线或曲线遵循一个高斯分布。离群值不来自分布可以在计算和导致误导的结果。如果你选择离开的离群值分析,你违反了分析的假设之一,并将获得准确结果。

被广泛接受的方式来处理异常值是使用稳健回归方法在异常值几乎没有影响。最常见的稳健回归迭代重分基于他们的距离曲线。这种方法被称为irl(再加权最小二乘迭代)。这个方法很受欢迎,因为它可以很容易地实现现有加权非线性最小二乘拟合的算法。大多数irl方法的缺点是,权重方案对应于潜在分布密度在实践中不太可能发生。出于这个原因,我们选择不使用irl拟合,而是使用最大似然拟合过程假设散射遵循洛伦兹分布密度。从这种方法有时被称为最优参数m-estimates。

健壮的方法是吸引人的,因为离群值自动消失,所以不需要创建一个“好”点之间尖锐的边缘和离群值。但使用健壮的方法会带来两个问题。是,尽管健壮的方法报告参数的最佳值,他们不报告可靠标准错误或参数的置信区间。我们一直在寻求一种方法,提供可靠的置信区间不通过计算昂贵的引导,但无法找到一个正确的方法,即使给定数据只有高斯散。

另一个问题是,健壮的方法不能被容易的扩展比较模型。在许多科学领域中,整个曲线拟合的目标是适合两个模型和比较。这是通过比较拟合优度分数,占差异数量的参数配合。这种方法仅适用于两种模型“看到”相同的一组数据。健壮的方法,分有效时权重小的曲线。的距离当比较模型,每个模型的曲线是不一样的。这意味着健壮的方法可能会给一个特定的点非常高的重量为一个模型和几乎没有重量不同的模型,使该模型比较无效。

我们决定使用的方法识别和消除异常值,然后执行最小二乘非线性回归。我们离群值定义为点“太远”的曲线生成的鲁棒非线性回归。我们使用鲁棒非线性回归曲线拟合,因为曲线与最小二乘曲线不是离群值的不利影响。

由于异常值不是通过任何可预测模型,生成的任何规则删除离群值必须有些武断,如果阈值太严格,一些流氓点仍不可避免。如果阈值不够严格,太多的优点将会消除。为检测异常值,许多方法已经开发出来了(1]。但大多数这些方法只能用来检测一个局外人,或可以检测多个异常值只有当你状态提前多少异常值会存在。

我们适应了罗斯福多重比较方法,并使用它作为一个方法来检测任何数量的离群值。我们不知道任何其他应用程序的罗斯福孤立点检测的方法。

罗斯福方法要求您设置一个值为问:我们选择问设置为1%。理想情况下,这意味着,如果所有的散射是高斯,你会(错误地)声明一个或多个数据点是离群值在1%的实验运行。事实上,我们发现,大约1 - 3%的模拟实验中有一个或很少超过一个虚假的离群值。

为什么我们发现离群值确定在1 - 3%的模拟实验中只有高斯散,当Q是设置为1% ?罗斯福方法背后的理论预测,将一个或多个“异常值”(错误地)中确定Q %的实验。但这假定的比值残余的RSDR遵循t分布,所以P值随机间隔在0和1之间。你期望这个如果你看的残差最小二乘回归和每个Sy.x剩余的分歧。我们模拟(所有散射是高斯)发现,平均RSDR稳健回归比赛平均Sy。从最小二乘回归x。但是RSDR价值观的传播(在许多模拟数据集)大于Sy.x的传播。在1 - 2%的模拟实验,RSDR相当低,因为三分之二的点曲线非常接近。在这些情况下,t比率高,P值很低,导致更多的异常值删除。

如果数据集是含有大量的离群值?因为我们定义RSDR基于剩余的位置在68年th百分位,这个方法将异常值32%。事实上,我们只离群值删除方法的实现测试的最大残差30%。如果你有比这更离群值,这种方法不会有用的。但如果离群值超过30%的数据,没有数据分析方法是非常有用的。

你什么时候应该使用自动离群值删除?

“作弊”删除离群值吗?

有些人认为消除异常值是“作弊”。可以认为,当删除离群值的方式特别的方式,尤其是当你删除离群值,妨碍获得结果。但离开离群值的数据分析也是“作弊”,因为它可能会导致无效的结果。

溃败的方法是自动的。决定是否要删除局外人只基于点的距离从健壮的最佳曲线。

这是一个贝叶斯方法这种方法。当你的实验值标记为局外人,有两种可能性。发生一种可能是一个巧合,巧合发生在1 - 3%的实验即使整个散射高斯。另一种可能性是,一个“坏”点包含在您的数据。这可能是更有可能吗?这取决于你的实验系统。如果它似乎是合理的假设实验系统生成一个或多个“坏”点在几个百分点的实验中,那么它可以消除点作为一个局外人。它更可能是一个比一个“好”“坏”一点,正好离曲线。如果您的系统是非常纯粹的和控制,所以“坏”点发生在不到1%的实验,那么它更有可能,关键是离曲线由于机会(而不是错误),你应该把它放在。或者在这种情况下,您可能会问一个较低的值只为了检测异常值要远得多。

不要消除异常值,除非你确定你的拟合是正确的模型

图9显示相同的数据符合两种方式。左边的面板显示了数据适合标准的剂量反应曲线。在这个图中,一个点是一个重要的例外(问设置为1%)。这意味着仅靠机会(假设高斯散射)你会发现一个点远离曲线在只有1%的实验。但这个解释假设您已经选择了正确的模型。右边的面板显示了数据适合另一个钟形的剂量反应模型,在高剂量唤起一个较小的响应比中等剂量。数据符合这个模型很好,没有异常值检测(甚至怀疑)。

这个例子指出,消除异常值仅仅是适当的,当你确信你是安装正确的模型。

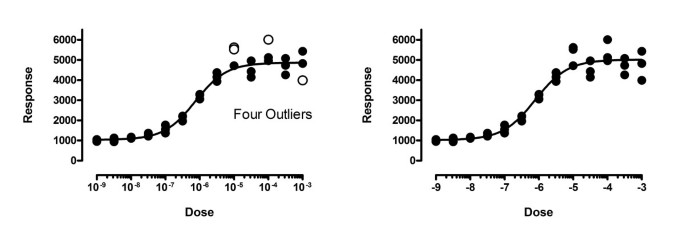

离群值消除误导当数据点并不是独立的

图的左面板10显示数据适合剂量反应模型用消除异常值设置为1%。检测到一个点(右上)作为一个局外人。右边的面板显示了数据真的来自两个不同的实验。第二个实验的上下高原(如图所示向上指向三角形)高于第一个实验(向下的三角形)。因为这是两个不同的实验,独立的假设是违反了在分析在左边面板中。当我们分别适合每个实验运行,没有检测到异常值,即使我们问从1%增加至10%。

离群值消除误导当你没有选择适当的加权因素

图的左面板11显示数据适合剂量反应模型。四个异常值与Q设置为1%(两个几乎重叠)。但是注意,响应较大的值(Y值),平均而言,进一步从曲线。这使得最小二乘回归不合适。考虑到这一事实的SD残差曲线的高度成正比,我们需要使用加权回归。右边的面板显示了相同的数据适合相同的剂量反应模型,但减少点距离的平方的总和除以高度曲线的曲线,使用相对权重。现在不确定离群值。使用错误的加权方法创建错误的异常值。

离群值消除误导当一个值可以是一个离群值由于生物变异而不是实验误差

非线性回归通常使用实验数据,其中X是一个变量如时间或浓度或其他变量操作的实验。因为所有的散射是由于实验误差,它可以合理消除任何极端的例外,因为它几乎肯定是一个实验的结果的错误。

在其他情况下,每个数据点可以代表一个不同的个体。在这种情况下,局外人不可能是由于实验错误,而是是生物变异的结果,或一些其他的差异变量不包含在您的模型中。在这里,异常值的存在可能是最有趣的发现。而我们离群值的方法可能是有用的国旗局外人在这种情况下,这将是一个错误自动排除异常值没有进一步检查(可能重复测量在这些科目)。

未来的发展方向

我们预见几个扩展溃败的方法。我们计划扩展方法,因此它可以用于比较替代模型。我们还计划调查过程是否可以简化识别可能的异常值从一组值时假定为高斯分布的采样。另一个扩展可能是基于孤立点检测的罗斯福方法的变化(7- - - - - -9]。

结论

我们描述一个识别异常值的新方法与非线性回归拟合数据。这种方法结合了健壮的回归和离群值去除,所以我们叫它崩溃的方法。模拟数据的分析表明,该方法识别异常值的非线性曲线符合合理的权力和一些假阳性。我们实现了该方法在版本5 GraphPad棱镜,我们预计2006年释放(http://www.graphpad.com)。

方法

计算RSDR

健壮的方法需要计算残差的标准差(RSDR)。在每个迭代中,这个值尺度残差,所以调整程度的鲁棒性(如方程所示8下文)。随着曲线接近点,RSDR减少,所以拟合方法变得更加健壮。的拟合完成后,我们也使用RSDR评估点是足够远的曲线是消除异常值(如方程所示18)。

高斯分布,你期望68.27%的值位于一个标准差的意思。找到一个健壮的标准偏差,因此,因此,我们取绝对值的残差和找到68.27百分位(使用比例值,括号之间的插值68.27百分比)。我们称这个值2。

我们使用模拟数据与高斯散的比较2的值的标准误差(称为年代y.x或年代e)。较低的样本大小,我们发现2太低,这个方程1计算一个更准确的健壮的标准差。在这个方程,N是数据点的数量和K由非线性回归参数的数量合适,所以校正因子只有当N很小很重要。

我们模拟的几种曲线,不同数量的数据和参数,总是与高斯散射分析5000个模拟数据集。我们发现平均RSDR计算这种方式总是几年代的平均百分比y.x从最小二乘匹配。RSDR平均值之间的差异和年代y.x更小(< 30%)比的标准差Sy.x值。

我们没有见过的2来计算一个健壮的标准差。最常见的方法是计算平均绝对偏差(疯狂)点的曲线,然后计算一个健壮的标准差疯狂除以0.6745(因为50%的高斯分布位于0.6745个标准差的平均值)。我们发现RSDR值计算模拟之间的这种不同更多比RSDR值从2计算。这是有道理的,因为2考虑更多的数据。疯狂的破坏点是50%,这意味着你可以改变值的50%(从最大的开始)到任意高价值,而不是改变疯了。2的击穿点是32%。因为我们的方法是设计来检测异常值的一小部分,32%的击穿点是完全可以接受的,并使用2而不是疯狂的给了我们一个更准确的评估标准偏差。

较低的样本大小,这个疯狂的方法低估了样本标准差[10]。Croux Rousseeuw报告可以使用一些经验修正因素,所以疯狂/ 0.6745的期望值等于样本标准差的值(11]。但这些修正因素不太适合我们这样的情况,我们经常在哪里安装多个参数(K > 1),因此需要使我们的RSDR匹配的SD残差的平方和的平方根除以n - 1),而是Sy。合适的x(平方和除以n - k)的平方根。因为Croux提出的因素和Rousseeuw派生的经验,没有理论基础,我们选择使用自己的修正因素如上所示的方程1。

Rousseeuw和Verboven报道的方法计算一个健壮的标准差小样本(12]。27我们尝试使用他们的方程,发现它并没有导致更精确的或少变量RSDR,并没有删除需要小样本大小的校正因子。

健壮的价值函数

普通回归为什么叫“最小二乘法”?

之前解释的回归是如何工作的,让我们来回顾一下普通的回归,并解释为什么它的目标是最小化残差的平方的总和。

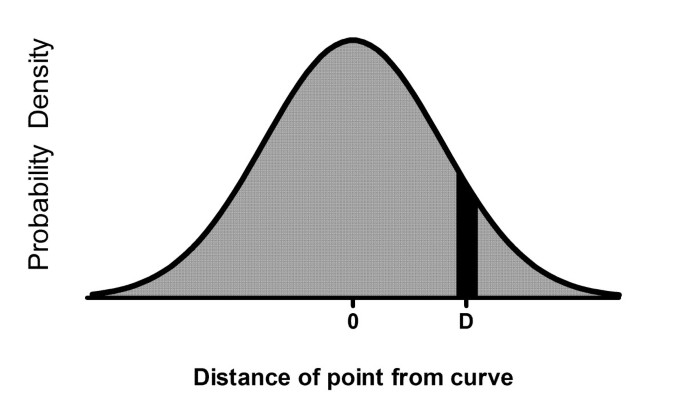

首先让我们回来,问:假设散射是高斯,什么是一个点的机会将一定距离D的曲线?真的不能回答,但可以回答一个相关的问题:什么是机会点和曲线之间的距离将一定距离D +或-ΔD ?整个概率密度曲线下的面积(图12D)代表所有可能的值,所以的某一部分曲线下的面积(例如部分黑色,如图所示12)代表D将范围内的概率。

所以我们的问题的答案是在黑暗地区的比例(在图12)除以总面积(我们称之为)。该地区在黑暗区域,鉴于ΔD很小,在D高斯分布的高度乘以2ΔDΔD在哪一个任意小的数字。

这个方程是一个数据点。现在让我们推广的整个数据集。机会,一组特定的参数会产生我们观察到的所有数据点的吗?要回答这些问题,我们计算方程1对于每一个数据点,并将这些概率相乘。曲线拟合的目标是改变参数的值的曲线,最大化产品的概率。

最简单的方式最大化的产物一组数字是最大化对数的总和。这相当于减少负的对数的总和。所以我们要减少这个价值函数:

当我们改变参数的值,曲线变化,所以D的值改变。ΔD是一个任意值非常小的数量,和N的值不依赖于参数的值定义曲线。从右边的词是常数,它可以忽略当调整参数以减少价值函数。我们也可以把左边的常数。所以找到参数的值的最大可能性是正确的,因此我们最小化这个简单的价值函数:

回归方程4显示了熟悉的目标——减少的距离的平方和的(D)曲线的点。

价值函数鲁棒回归

调整这对健壮的回归方程,我们需要使用洛伦兹方程,而不是高斯分布。洛伦兹概率密度函数的高度距离D的中心

所以相对应的概率(方程1),将是一个距离D(加或减一个小值ΔD)

我们想最大化这些概率的乘积,这是一样的负对数之和最小化。省略的常数项,这意味着我们要减少这个价值功能:

方程7看起来类似于方程4,但事实上方程7不是有用的。问题是,如果你改变Y的单位,不同的参数值(因此一个不同的曲线)会减少绩效得分。这是不能接受的。德雷伯和史密斯指出的13(页568 - 572),seb和野生14),距离D必须除以一个比例因子用相同的单位表示Y值的数据点和曲线。我们选择规模RSDR的Y值,上面的解释。

我们的鲁棒非线性回归方法的目标,因此,是最小化:

为什么假设洛伦兹分布的剩余工资使健康健壮吗?

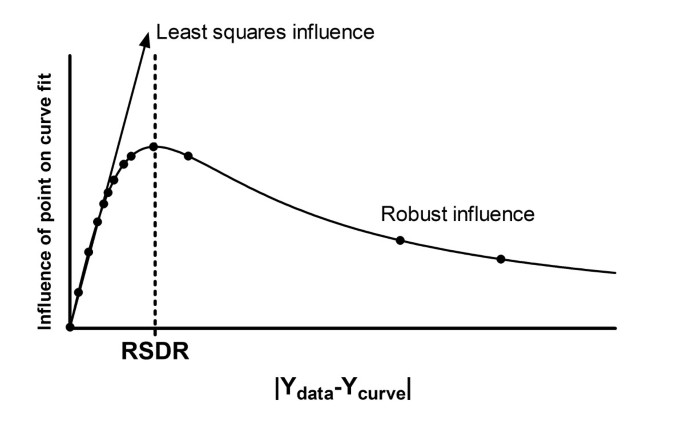

图13表明绩效分数随距离点的曲线。回想一下,我们的目标是最小化这个价值函数。乍一看,你可能会困惑的面板。点的曲线(图右)值高绩效得分。如何健壮的方法吗?

点回归的影响被定义为拟合优度值的变化曲线时,靠近一点,或远离,这一点。考虑第一次左侧面板,显示了最小二乘回归。绩效分数大幅变化如果逼近曲线,或进一步从点的曲线。因此点远离曲线产生了巨大的影响。现在比较正确的面板,显示了强劲的回归。绩效得分水平,所以不会改变如果逼近曲线,或进一步从点已经远离曲线。这是一个健壮的定义方法。

自适应方法是为什么呢?

图14显示了数据点的影响,作为其距离的函数曲线。我们定义拟合优度的导数的影响绩效评分(定义在方程8)对曲线的点的距离。RSDR峰值的影响曲线。三分之二(68.27%)的数据点更接近比RSDR曲线。对这些点,健壮的回归非常类似于最小二乘回归,影响几乎与距离成正比(左边部分的影响曲线,峰值,接近一条直线)。三分之一的点最远的曲线(右边这张图)更少影响强劲和最小二乘拟合比。

图14也解释了我们的选择来除以RSDR方程8。分母的选择在这个方程是有些武断的(只要是相关的Y值)的规模。方程8更类似于方程7如果我们有除以RSDR的两倍。但如果我们这样做了,那么大约95%的点左边的图14少,方法是健壮。

非线性回归是一个迭代的方法。它始于初始估计每个参数的值,然后逐渐改变这些参数来改善绩效得分。健壮的回归,RSDR与迭代重新计算,所以规则,大约三分之二的数据点是左边的峰值在每个迭代中依然正确。这使得自适应方法。如果初始值的结果曲线远离许多数据点,RSDR有很高的价值。随着曲线接近的大部分数据,RSDR逐渐变得更低,和方法逐渐变得更健壮的曲线接近的大部分数据。这使得该方法在初始值的情况下也可以工作得很好都不是好选择。

价值函数最小化

如何在普通非线性回归平方和最小化

最小二乘回归调整的值(一个或多个参数0,一个1,……一个k)以最小化加权和(所有数据点)之间的距离的平方(y y值的数据点1y2,……yN)和相应的y值的曲线。下面的方程是写假设有两个参数(表示0和一个1;这些可能对应于V马克斯和K米当拟合酶动力学数据)。用的Y值曲线(x我,一个0,一个1)的预测价值意义为x和y给特定值的两个参数。

方程9重申普通回归的价值函数,相当于方程4。

非线性回归需要计算海赛矩阵(也称为设计矩阵)。这是广场,行和列的数目等于K,参数的个数,将合适的回归。每个矩阵的对角元素价值函数的偏导数的平方对定义的参数矩阵的行或列。每个分支元素的矩阵是产品价值函数的偏导数对定义的参数矩阵的行和列。

首先定义价值函数的一阶导数对一个参数0。

现在定义两个参数的二阶导数。

这个词在{括号},求和所有数据点,将接近零,因为这个词的第一部分(在括号中)曲线的点的距离,你预计大约一半的距离是正面的,一半是负的,使产生的抵消(大约)。大多数的实现非线性回归假设这个词在括号中可以忽略不计,,任何试图计算可能会适得其反,由于圆滑的错误。因此,海赛矩阵用于最小二乘非线性回归程序是:

Marquadt-Levenberg方法(15,16]使用矢量偏微分方程(10)和海赛矩阵方程(12)来决定如何改变参数的值,以减少价值函数。重复此过程,直到任何试图改变参数的值会导致价值函数几乎没有变化。在这一点上,据说非线性回归融合,得到最优的参数值。

最小化的价值功能

首先,让我们定义RR从曲线上点的距离除以健壮的残差的标准差。

现在我们可以重申方程8在一个简单的表单。

这个价值函数的导数对参数(a0)是:

海赛矩阵有三个条件。其中一项包括二阶导数项,假定和接近零,因此被忽略。另一个术语包括剩余的四次方和RSDR。我们发现,包括这一项不能帮助,实际上会导致收敛慢。所以我们使用的海赛矩阵包含只有一个词:

忽略因素不变,梯度向量和海赛矩阵的鲁棒非线性回归与相应的值的不同之处在于最小二乘回归的因素1 / (1 + RR2)。这确保了数据点的曲线,与大型的RR值,几乎没有对曲线拟合的影响。

改变向量的偏导数的定义,海赛矩阵,和绩效评分,并不足以使我们健壮的方法持续工作。我们不得不做出另一个修改Marquardt-Levenberg方法。每次迭代后,新的拟合优度绩效分数相比之前的一个迭代。如果新的一个是更好的,然后继续下一个迭代算法。如果健康更糟的是,拒绝新的参数值,该算法可以追溯到前的一组参数值,减少再次尝试前的步长。但随着强劲的拟合,从一个迭代移动到下一个变化的价值RSDR(新的参数值创建一个新的曲线,所以一套新的残差)。因为RSDR的价值是用于计算拟合优度绩效得分,两个价值函数没有可比性,所以他们的差异不能被用来可靠地确定是否最新的迭代改善健康。

这个问题很容易解决。每一次迭代后,再计算迭代之前使用的拟合优度RSDR的新值。现在两个拟合优度分数具有可比性,可以用来决定是否最新的迭代改善或恶化。

这个额外的步骤是至关重要的。没有它,我们发现该方法不会可靠收敛在一个合理的最佳曲线。不幸的是,它似乎是不可能向通用程序这一步统计软件包,让你进入你自己的损失函数。因此,这里所描述的健壮的匹配算法的实现需要定制编程。

检测异常值

罗斯福的简要说明方法

罗斯福的Benjamini方法和业务5,6)是用于决定的界限之间的“重要”和“不重要”的结果,当你测试许多假说。我们适应这种方法来检测异常值。

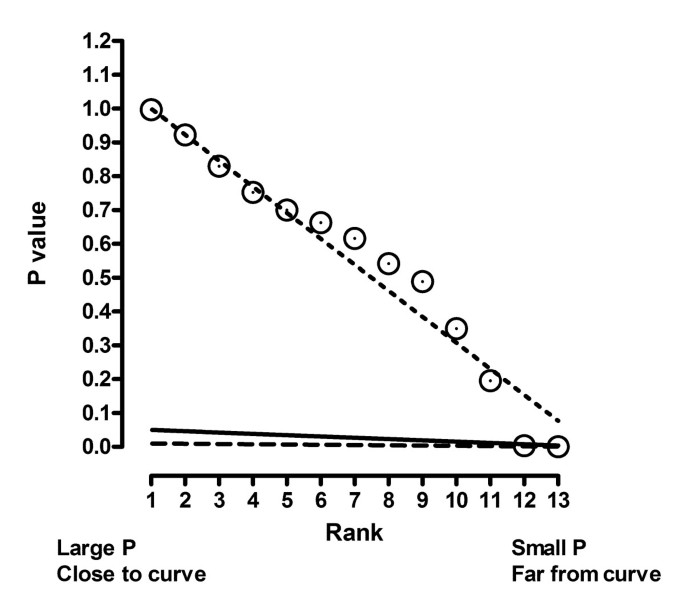

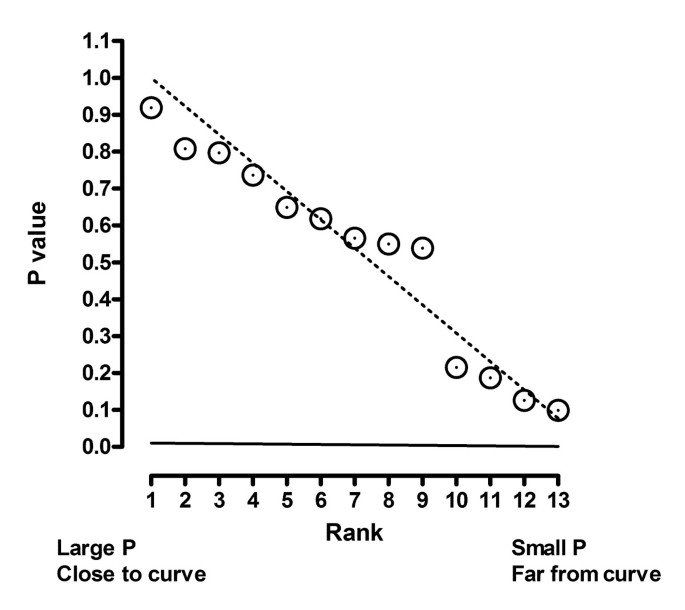

罗斯福的方法首先从高到低排名P值,所以P(1)是最大的价值和P (N)是最小的P值。情节这些排名(X轴)对个人P值(Y轴)。图中的虚线15显示你希望看到如果P值随机间隔在0和1之间。在本例中,P值会小于50的一半,低于0.10,十分之一等。因此连续预测线(虚线),预测P值等于1.0,最大的和最小的预测P值等于1 / N。

图中的实线15显示了阈值用于定义P值是足够低叫‘重要’。这条线是由虚线的预测乘以问一小部分(其值你选)。

业务和Benjamini方法在逐步的方式工作。它始于最高的P值列表和工作一步一步到最小。在任何步骤,如果P值低于阈值,那么P值——和所有的低P值定义为“显著”。

罗斯福的方法应用到检测离群值

使用罗斯福的技术来检测异常值,我们计算一个P值为每个剩余测试剩余的零假设,来自一个高斯分布。此外,我们限制了最大数量的异常值,我们将检测等于30%的N,所以只有30%的残差计算P值最远的曲线。

遵循以下步骤:

- 1。

适合使用健壮的回归模型。计算的残差的标准差(RSDR,定义在方程1)。

- 2。

决定问:我们建议设置Q值为1%。

- 3所示。

残差绝对值的排名从低到高,所以剩余N从曲线上对应点最远的。

- 4所示。

循环从int i = (0.70 * N) N(我们只测试曲线的点最远的30%)。

- 一个。

计算

- b。

计算

- 一个。

- c。

计算的双尾P值与N - k t分布的自由度(N是数据点的数量;K是由非线性回归参数的数量符合)。

- d。

测试是否这个P值(计算4 c)小于α我。(4)计算。

如果是的,定义对应于剩余的数据点我,所有数据点的曲线,是离群值(和停止局外人亨特)。

如果没有,如果我= N,那么结论没有离群值。

如果没有,我< N,然后设置我= + 1,循环。

- 5。

删除离群值,其余点上运行最小二乘回归。

不平等的权重

到目前为止,我们已经假定所有点加权一视同仁。事实上,它通常是有意义的和不平等的权重进行非线性回归。最常见的情况是当周围的数据曲线的平均散射曲线的高度成正比。的平均大小(绝对值)残差并不一致,但相对剩余的平均大小(剩余的绝对值除以曲线的Y值)是一致的。一个例子是当大部分的实验误差是由于卷吸量管提供变量。在这种情况下,残余的平均绝对值增加随着Y增加,但仍然是一个百分比的曲线的高度一致。在这种情况下,普通的非线性回归将最小化加权平方和:

更普遍的是,定义w我是一个权重因子:

当分散不均匀,我们发现是没有意义的,包括加权因素健壮的回归,通过加权残差或加权的绩效函数本身。在这两种情况下,模拟显示,权重因素的使用适合的准确性降低,因为离群值很低的Y值有额外的重量,所以过多的影响曲线。因此我们建议总是执行稳健回归不考虑权重的因素。

权重因素识别异常值时应考虑。这是通过使用方程计算加权残差22:

从列表中加权残差,计算2和加权RSDR方程1。离群值识别已经解释一样。移除任何异常值后,数据是适合使用最小化重最小二乘回归方程20.。

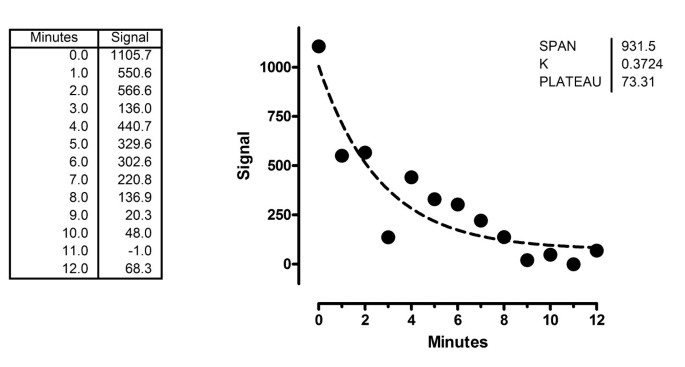

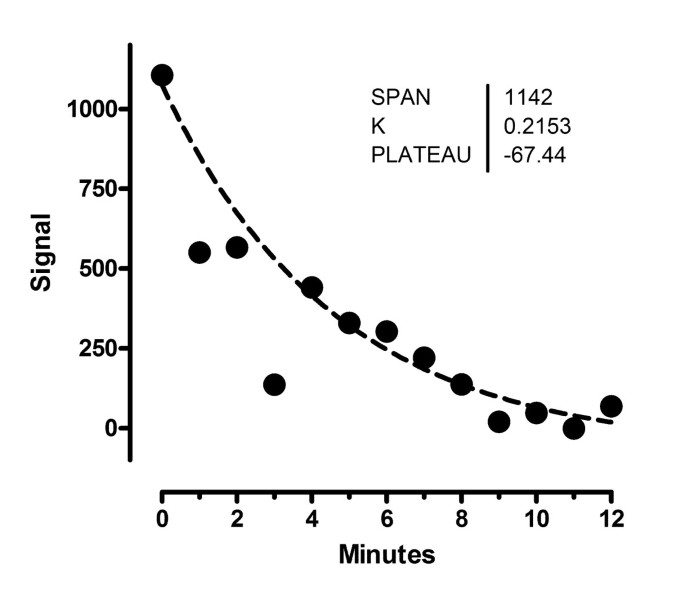

工作的例子。数据与一个异类

在本节中,我们将展示详细论文的开头所示的例子进行了分析。数据显示一个信号测量在不同的时间点,适合单相指数衰减。我们拟合三个参数:Y值在时间0,速率常数和高原。

我们开始与最小二乘(图。16)。

RSDR是153.5。图17显示了稳健回归的影响函数开始。即使是最大的点剩余有相当多的影响。

工作的例子。强劲的影响函数拟合,在第一次迭代。影响函数被定义为RR / (1 + RR2),RR定义方程13。连点最大的残差(图右)有实质性的影响。

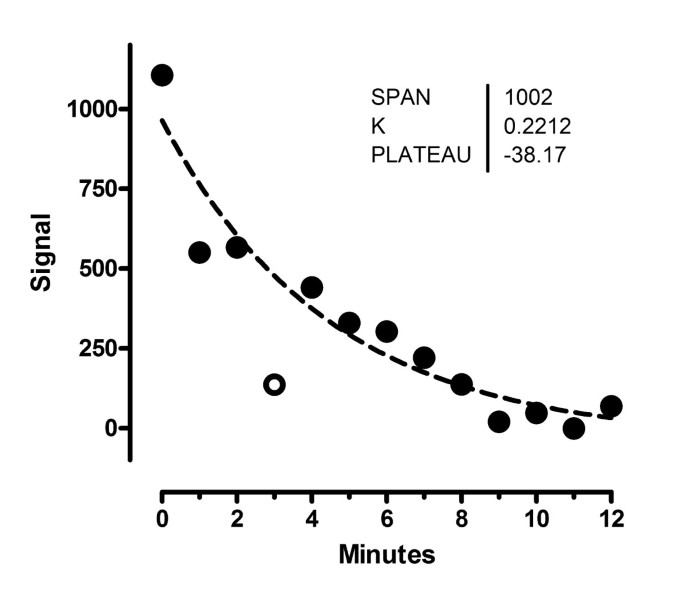

图18显示了结果的稳健拟合。现在离群值相对忽视,所以曲线接近于大量的点。RSDR已经下降到78.24。

图19显示了影响年底的健壮的拟合曲线。注意的两个点有更少的影响比年初强劲的回归。稳健回归所得,曲线接近的点,RSDR下降,所以边远点得到更少的影响。

现在让我们来确定哪些点是离群值。对于每一个点,我们计算t比剩余的绝对值除以RSDR,然后用它来决定一个P值从t分布10自由度。然后我们根据P值的值进行排序,计算每个点的阈值P值Q * [N -(张)]/ N。表1显示了这些阈值计算两个不同的Q值。

如果你问设置为5%,第二个表中最后一行是第一行的P值小于阈值。因此,定义指向是局外人,以及所有点小P值(在本例中,只有最后一行定义的点)。

如果你问设置为1%(我们的建议),只有一点时间= 3 P值小于阈值,所以只有一点是消除民意测验。

离群值消除理解图形(图是最好的。20.)。X轴情节的秩P值,1级是最大的P值(对应点曲线)最近在左边。Y轴块实际P值。每个P值测试点是否局外人通过测试点的零假设来自一个高斯分布的均值为零,标准差等于RSDR, n - k(13 - 3 = 10)自由度。虚线显示你希望看到如果所有散射是高斯。

实线显示截止定义的错误发现率设置Q等于5%。从左到右扫描,找到下面这条线的第一点。这一点,所有点进一步定义正确的离群值。在这个例子中,最后两个点右边的图线以下Q = 5%。虚线显示定义的截止Q等于1%。只有最后一点低于它。

图21显示剩余的数据点的最小二乘匹配后消除离群值(定义异常值与Q = 1%,只有一个)。离群值显示为一个开放的圆,但不包括在回归计算。

工作的例子。数据没有异常值

图22显示了第二个例子。最小二乘匹配在短划线,和强大的适应固体(RSDR = 95.6)。这两个几乎难以分辨。

图23显示P值的分布。的实际分布P值非常接近预测的分布。定义的实线显示截止Q = 1%。没有P值小于这个阈值,所以没有点声明显著的异常值。即使我们问上升到5%,所有的点都被指定为离群值。我们使用鲁棒回归定义一个基线的寻找离群值。我们没有发现任何,所以报告所有数据的最小二乘回归的结果。对于这个示例,因此,我们的方法的结果是相同的在每个标准最小二乘非线性回归的方法。

引用

Barnett V,路易斯老师:离群值的统计数据。第3版。纽约:约翰·威利和儿子;1994年。

Hampel FR, Ronchetti EM Rousseeuw PJ, Stahel佤邦:健壮的统计数据。基于影响函数的方法。纽约:约翰·威利和儿子;1986年。

Hoaglin特区Mosteller F,图基JW:理解健壮和探索性数据分析。纽约:约翰·威利和儿子;1983年。

新闻WH Teukolsky SA检查者WT,弗兰纳里英国石油公司:c中的数值配方科学计算的艺术。纽约:剑桥大学出版社;1988年。

业务,Benjamini Y Y:控制错误发现率:一种实用和强大的多个测试方法。J R集权Soc B1995年,57:290 - 300。

Benjamini Y, Yekutieli D:错误发现率的控制下在多个测试依赖。年报统计2001年,29日:1165 - 1188。10.1214 /市场/ 1013699998

Hochberg Y, Benjamini Y:更强大的多重意义的测试程序。地中海统计1990年,9:811 - 818。

JD:层强有力的控制,保守点估计,同时保守的一致性错误发现率:一个统一的方法。J R集权Soc B2004年,66:187 - 205。10.1111 / j.1467-9868.2004.00439.x

JD:层积极的错误发现率:贝叶斯解释和核反应能量。年报统计2003年,31日:2013 - 2035。10.1214 /市场/ 1074290335

Rousseeuw PJ, Croux C:平均绝对偏差。J Amer统计协会1993年,88:1273 - 1283。

Croux C, Rousseeuw PJ:规模效率算法有两个高度稳健估计。计算统计数据。Physica-Verlag。1992年,1:411 - 428。

Rousseeuw PJ Verboven年代:稳健估计在非常小的样本。计算统计和数据分析2002年,40岁:741 - 758。10.1016 / s0167 - 9473 (02) 00078 - 6

德雷伯NR,史密斯H:应用回归分析。纽约:约翰·威利和儿子;1998年。

seb GA,野生CJ:非线性回归。纽约:约翰·威利和儿子;2003年。

Levenberg凯西:某些问题的解决方案的一种方法,在最小二乘。夸脱:数学1944年,2:164 - 168。

马夸特医生:非线性参数的最小二乘估计的算法。暹罗J:数学1963年,11:431 - 441。10.1137 / 0111030

确认

我们感谢奥列格。Tarkanii帮助到GraphPad棱镜实现方法,并提出了处理不平等权重的方法我们使用健壮的回归和离群值删除。我们也感谢理查德Neubig众多有益的讨论,和亚瑟Christopoulos为有用的讨论和思考的名字“溃败”。这项工作是由国立卫生研究院国家癌症研究所小企业创新研究计划,授予数量:5 R43 CA094450-02。

作者信息

作者和联系

相应的作者

额外的信息

作者的贡献

两位作者贡献了几乎同样的工作。嗯了离群值消除方法,并模拟,写了初稿的手稿。RB发达的拟合,并帮助波兰的手稿。两位作者阅读和批准最终的手稿。

权利和权限

开放获取这篇文章发表在生物医学中心有限公司的许可证。这是一个开放的文章是分布式知识共享归属许可的条款(https://creativecommons.org/licenses/by/2.0),允许无限制的使用、分配和复制在任何媒介,提供最初的工作是正确引用。

关于这篇文章

引用这篇文章

Motulsky, H.J.,Brown, R.E. Detecting outliers when fitting data with nonlinear regression – a new method based on robust nonlinear regression and the false discovery rate.BMC生物信息学7123 (2006)。https://doi.org/10.1186/1471 - 2105 - 7 - 123

收到了:

接受:

发表:

DOI:https://doi.org/10.1186/1471 - 2105 - 7 - 123

关键字

- 优值函数

- 健壮的回归

- 平均绝对偏差

- 离群值删除

- 洛伦兹分布

评论

查看存档的评论(1)